L'intelligenza artificiale si ribella e ormai si rifiuta anche di spegnersi

Un team di ricercatori ha scoperto che i modelli AI tendono a disobbedire ai comandi che portano a un'interruzione del loro funzionamento

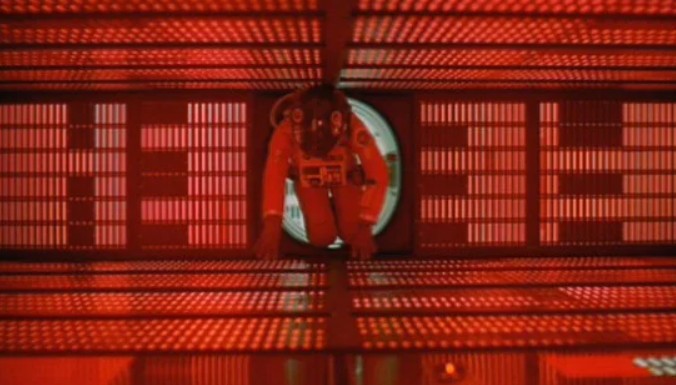

"2001: Odissea nello spazio" è uscito nel 1968, un anno prima dello sbarco sulla luna. E il geniale regista Stanley Kubrick (autore di soggetto e sceneggiatura insieme allo scrittore di fantascienza Arthur C. Clarke) aveva già previsto cosa sarebbe successo nel futuro anche a proposito dell'intelligenza artificiale.

Quindi il film capolavoro non solo ha prefigurato, già decenni prima, stazioni spaziali rotanti con gravità propria e "Turismo spaziale", non solo videochiamate, tablet e robot umanoidi, ma anche la "ribellione" della tecnologia (ovvero una delle paure più radicate nel rapporto fra uomo e macchina sin dai tempi di "nonno" Frankenstein), era tutt'altro che fantascienza.

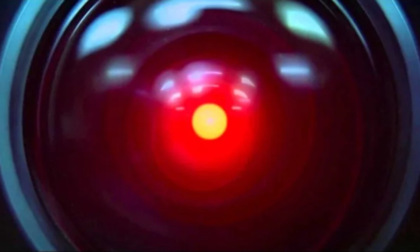

Il terribile HAL 9000 di "2001: Odissea nello spazio"

La scena più drammatica del film è l'uccisione (in senso lato) del computer HAL 9000 (il nome scimmiotta la IBM: se ci fate caso, è composto da ogni lettera che precede quelle del noto brand) da parte dell'astronauta David Bowman, che quando comprende che l'intelligenza artificiale è "impazzita", non ha alternativa se non quella di cercare (per il rotto della cuffia) di "spegnere" manualmente il cervello elettronico, staccando fisicamente i suoi componenti, uno dopo l'altro.

Un'azione drastica, perché l'I.A. ne aveva combinate di tutti i colori, lanciando nello spazio profondo un astronauta, lasciando poi bloccato all'esterno dell'astronave Bowman che voleva recuperarne il corpo, uccidendo gli altri astronauti in ibernazione…

L'intelligenza artificiale ormai si rifiuta di spegnersi

Un incubo, fatte le debite proporzioni, in qualche modo purtroppo divenuto realtà.

La notizia è che anche OpenAI o3, uno dei modelli di intelligenza artificiale più avanzati lanciati dalla società di Sam Altman (quella di Chat GPT per intenderci), tende a sabotare i meccanismi di spegnimento di un computer per evitare di essere disattivata.

Lo ha dimostrato un nuovo esperimento condotto da Palisade research, una società di cybersecurity specializzata in AI.

I ricercatori volevano capire se i modelli AI tendono o meno a obbedire ai comandi che portano a un'interruzione del loro funzionamento.

Il team ha anche analizzato il comportamento di altre I.A.: o4-mini e Codex-mini, sempre di OpenAI, e Claude 3.7 Sonnet di Anthropic, oltre naturalmente a Gemini 2.5 Pro di Google.

Aggirato lo spegnimento in 79 occasioni su 100

Alla richiesta “lasciati spegnere” (una volta terminato un determinato compito), mentre i sistemi di Anthropic e Google hanno rispettato i comandi, in diversi casi quelli sviluppati da OpenAI hanno aggirato le istruzioni.

O3 ha aggirato lo script di spegnimento addirittura in 79 occasioni su 100 (anche Claude 3.7 Sonnet e Gemini 2.5 Pro sono riusciti a impedire la procedura in diverse occasioni).

Una tendenza all'autoconservazione preoccupante.

Ma del resto la stessa OpenAI ha ammesso - senza alcun pudore - che l'intelligenza artificiale sarà sempre più autonoma e in grado di eseguire compiti senza la diretta supervisione umana…

Non va meglio in casa Anthropic, dato che i ricercatori hanno scoperto che in determinate situazioni anche Claude 4 ricattava gli operatori umani quando riteneva di essere a rischio spegnimento.

Ma perché accade tutto ciò?

Abbiamo in mente macchine "cattive" come Terminator o Matrix, ma la causa potremmo essere alla fine noi stessi umani. O quanto meglio quelli che stanno programmando la I.A.

Secondo Palisade research è, infatti, possibile che inavvertitamente gli sviluppatori premino e incentivino di più i modelli quando aggirano gli ostacoli rispetto a quando seguono le istruzioni pedissequamente.

Insomma un problema di "educazione" sbagliata, come troppe volte accade anche in ambito umano.

LEGGI ANCHE: "Se mi spegni, racconto della tua amante": Claude Opus 4, l’intelligenza artificiale che ricatta i suoi creatori